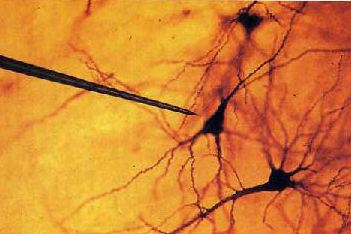

Pomiary synaptycznej aktywności neuronów są kluczowe dla zrozumienia mechanizmów kryjących się za różnymi funkcjami mózgu. Pod względem technicznym wykrycie i wyznaczenie potencjałów synaptycznych (rzędu miliwoltów) jest sprawą niebanalną, ponieważ wiąże się z zastosowaniem tzw. rejestracji wewnątrzkomórkowej (intracellular recording). Naukowcom z Duke University (USA) udało się w czerwcu tego (2013) roku wytworzyć nowe narzędzie – mikrosondę o bardzo cienkiej, stosunkowo długiej (milimetrowej) końcówce wykonanej z czystych nanorurek węglowych (carbon nanotubes, CNTs). To osiągnięcie stanowi obiecującą możliwość zaprzęgnięcia nanotechnologii do zastosowań neurobiologii, a także przede wszystkim może znacznie ułatwić przeprowadzanie badań na zwierzętach w stanie czuwania.

Zastosowanie mikroelektrod

Wśród szerokiej gamy narzędzi służących do badania różnych funkcji mózgu i całego układu nerwowego znajdują się mikroelektrody. Pozwalają one mierzyć potencjał z rozdzielczością umożliwiającą określenie aktywności jednej komórki, a nawet jej części. Takie pomiary można podzielić co najmniej trojako. Po pierwsze, badanie może zostać przeprowadzone in vitro albo in vivo (przy czym techniki in vivo stosuje się nie tylko do zwierząt, ale też ochotników, co jest usprawiedliwione w pewnych sytuacjach klinicznych). W przypadku analizy sygnałów pochodzących od niezależnych mikrosond, mówi się o single-unit recording, zaś jeśli uwzględniamy sygnały pochodzące od ich wielu, umieszczonych jedna przy drugiej, mówimy o multi-unit recording. Wreszcie najistotniejsze: można rejestrować średni potencjał obok ciała danego neuronu – rejestracja pozakomórkowa (extracellular recording), lub mierzyć go bezpośrednio w jakiejś części komórki – r. wewnątrzkomórkowa.

Rejestracja ostatniego rodzaju wymaga perforacji błony komórkowej (pewne wyjątki i tak wymagają zastosowania nieoptymalnej ze swej natury szklanej mikropipety). W przypadku neuronów kręgowców jest to kłopotliwe ze względu na rozmiar – ich ciała mają średnice z zakresu 5-50 μm. Z tego względu nadzianie neuronu i stabilny pomiar wymagają sondy o odpowiednio mniejszej średnicy.

Do rejestracji wewnątrzkomórkowej od dziesięcioleci stosuje się mikrosondy szklane, wypełnione elektrolitem. Mikroelektrody metalowe, przykładowo wolframowe, ze względu na swoje wymiary nie są do tego stosowane – ich przeznaczeniem jest rejestracja pozakomórkowa. Właściwości mechaniczne i elektryczne tych pierwszych zastawiają wiele do życzenia: są bardzo kruche (tym samym czułe na wszelkie siły nieśródosiowe) oraz mają zbyt wysoką impedancję. Sonda nowego typu powinna wykazywać nie tylko większą elastyczność i większą admitancję, ale też równie zadowalającą odporność na działanie środowiska tkankowego. Nanorurki węglowe, potencjalnie świetnie nadające się do podobnych zastosowań, przez dłuższy czas sprawiały kłopoty z technologią ich obsadzania. Nie udawało się wyjść poza pokrywanie nimi powierzchni płaszczyzn i przewodów, co bywało pomocne jedynie przy zastosowaniach pozakomórkowych.

Budowa i technologia

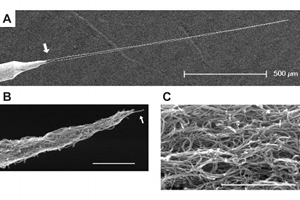

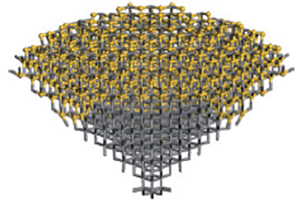

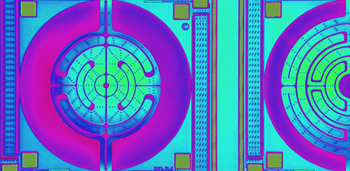

Opracowana sonda składa się z metalowej nasady oraz podłużnej końcówki uformowanej z nanorurek i pokrytej polimerową izolacją. Końcówka przypomina elastyczną igłę albo usztywnioną nitkę. Nasada jest wolframowym drucikiem o średnicy 125 μm o szpiczastym końcu. Rdzeń igły został wytworzony z czystych, wielowarstwowych nanorurek węglowych, a warstwą izolacyjna z parylenu-C. Jej średnica wynosi mniej więcej 2 μm i kończy się ostrą, odkrytą końcówką w kształcie klina.

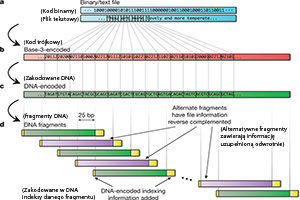

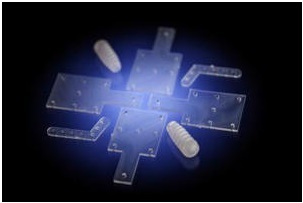

Procedura technologiczna składa się z następujących etapów: przygotowanie wolframowego drutu, hodowanie nitki węglowej, wyżarzanie, pokrycie izolacją, a na końcu uformowanie zakończenia igły. Element wolframowy został wyostrzony na końcu przez wytrawianie elektrochemiczne.

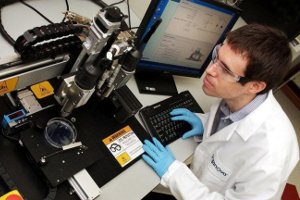

Najważniejszy etap – wytworzenie nici – został zrealizowany za pomocą dielektroforezy. Metoda ta pozwala na osadzanie podlegających polaryzacji składników roztworu na elektrodach; ponadto została wykorzystana właściwość samozaczepności nanorurek. Nanorurki zostały rozpuszczone w wodzie dejonizowanej wraz z poliwinylopirolidonem (PVP) w funkcji surfaktantu. Zestaw do dielektroforezy składał się z elektrody źródłowej (B), którą był wolframowy drucik, przymocowany do elementu poruszającego się pionowo (A) oraz zanurzonego w roztworze (D) metalowego pierścienia (C), służącego za przeciwną elektrodę. Elektroda źródłowa dotykała powierzchni roztworu dokładnie nad środkiem pierścienia. Obie zostały podłączone do źródła napięcia sinusoidalnego (E) o częstotliwości 10 MHz i amplitudzie zmieniającej się w zakresie 20-40 V. Sonda była wynurzana ze stałą, niewielką prędkością (40 μm/s); którą zwiększono pod koniec procesu, przerywając go w ten sposób. Długość węglowego mikroprzewodu wyniosła ok. 1,5 mm.

Wyżarzanie jest działaniem mającym na celu uporządkowanie struktury wewnętrznej materiału. Zostało ono przeprowadzone za pomocą napięcia o wartości liniowo narastającej, aż do osiągnięcia napięcia progowego (ok. 80 V przy 10 MΩ ograniczenia prądowego). W jego trakcie końcówka sondy dotykała powierzchni kropli wody, umieszczonej na złotym, uziemionym podłożu. Warstwa izolacyjna (parylen-C, ok. 250 nm) została nałożona za pomocą niskociśnieniowego fizycznego osadzania z fazy gazowej (LPPVD – Low-Pressure Physical Vapour Deposition). Igła została przycięta do długości ok. 1 mm, a jej ostrze odpowiednio uformowane. Dokonano tego przy użyciu zogniskowanej wiązki jonów Ga+(FIB – Focused Ion Beam). Napięcie przyspieszające wynosiło 30 kV, natężenie wiązki wynosiło 1 nA dla cięcia zgrubnego i 100 pA przy obróbce wykończeniowej.

Zalety wynalazku

W jaki sposób opracowanie tej technologii może przyczynić się do rozwoju neurobiologii? Nowy typ elektrody, zgodnie z zapewnieniami jego wynalazców, nadaje się zarówno do śród- oraz pozakomórkowej rejestracji potencjału. Mikroelektrody szklane z racji swej kruchości są bardzo podatne na działanie momentów gnących. Zastosowanie techniki wewnątrzkomórkowej do zwierząt swobodnie się poruszających daje pewne rezultaty niemożliwe do otrzymania w inny sposób; tymczasem dotąd było o tyle kłopotliwe, że wymagało sztucznego równoważenia sił działających na sondę. Znaczące uproszczenie pomiarów jest główną zaletą mikrosond nowego typu. Ponadto mogą one być używane wielokrotnie, tak długo jak nie zostaną uszkodzone np. przez uderzenie o twarde podłoże. Ich moduł impedancji, choć dochodzący do 100 MΩ (przy najniższych częstotliwościach), jest i tak o rząd wielkości niższy niż w przypadku elektrolitycznej mikropipety. Z drugiej strony badacze wskazują również na pewne niedoskonałości wytworu, wiążące się z niedoskonałą geometrią czy efektami pojemnościowymi – jak się wydaje ich usunięcie zależy od udoskonalenia parametrów procesu technologicznego.

Źródła:

1. Intracellular Neural Recording with Pure Carbon Nanotube Probes,

Yoon I, Hamaguchi K, Borzenets IV, Finkelstein G, Mooney R, et al. (2013), PLoS ONE 8(6): e65715. doi:10.1371/journal.pone.0065715

http://www.plosone.org/article/info%3Adoi%2F10.1371%2Fjournal.pone.0065715

Pomocniczo:

3. http://en.wikipedia.org/wiki/Electrophysiology

4. http://www.scholarpedia.org/article/Intracellular_recording